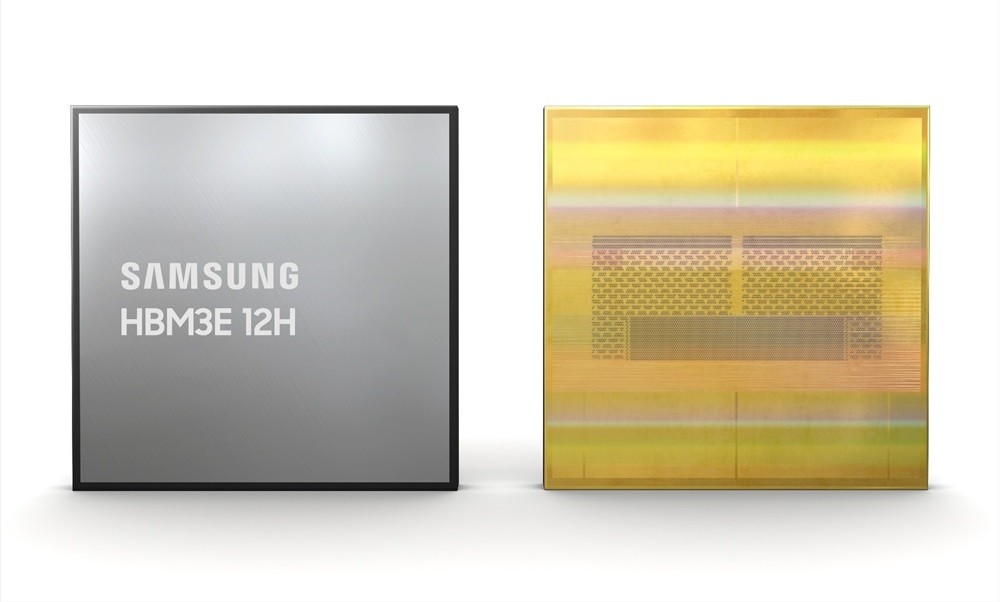

سامسونگ بهتازگی HBM3E 12H DRAM را با فناوری پیشرفته TC NCF معرفی کرد – طرفداران حروف اختصاری باید از خواندن این متن هیجانزده شوند، اما برای همه افراد دیگر در اینجا به معنای آن است. HBM مخفف “حافظه با پهنای باند بالا” است و آنچه را که روی قلع می گوید انجام می دهد.

در ماه اکتبر، سامسونگ HBM3E Shinebolt را معرفی کرد، نسخه پیشرفتهای از نسل سوم HBM که میتوانست به ۹.۸ گیگابیت بر ثانیه در هر پین (و ۱.۲ ترابایت در ثانیه برای کل بسته) دست یابد.

بعد، ساعت ۱۲ این به سادگی تعداد تراشه هایی است که به صورت عمودی در هر ماژول انباشته شده اند، در این مورد ۱۲ عدد. این راهی برای جا دادن حافظه بیشتر در یک ماژول است و سامسونگ با کیس ۱۲H به ۳۶ گیگابایت رسیده است، ۵۰ درصد بیشتر از طراحی ۸H. با این حال، پهنای باند ۱.۲ ترابایت بر ثانیه باقی می ماند.

در نهایت، TC NCF. این مخفف عبارت Thermal Compression Non Conductive Film است، یعنی موادی که در بین تراشه های روی هم قرار گرفته اند. سامسونگ روی نازکتر ساختن آن تا ۷ میکرومتر کار میکند، بنابراین پشته ۱۲H تقریباً به همان ارتفاع پشته ۸H است و امکان استفاده از بستهبندی HBM مشابه را فراهم میکند.

مزیت اضافی TC NCF باعث بهبود خواص حرارتی برای کمک به بهبود خنک کننده می شود. حتی بهتر از آن، روش استفاده شده در این DRAM جدید HBM3E 12H نیز بازده را بهبود می بخشد.

این حافظه برای چه چیزی استفاده خواهد شد؟ همانطور که باید بپرسید – هوش مصنوعی این روزها همه چیز تبلیغاتی است. اگر بخواهیم انصاف داشته باشیم، برنامه ای است که به رم زیادی نیاز دارد. سال گذشته انویدیا سامسونگ را به لیست تامین کنندگان حافظه با پهنای باند بالا اضافه کرد و این شرکت طراحی های دیوانه کننده ای را ایجاد کرد.

پردازنده گرافیکی Nvidia H200 Tensor Core دارای ۱۴۱ گیگابایت HBM3E است که در مجموع با سرعت ۴.۸ ترابایت بر ثانیه کار می کند. این بسیار فراتر از چیزی است که در یک GPU مصرف کننده با GDDR مشاهده می کنید. به عنوان مثال، RTX 4090 دارای ۲۴ گیگابایت GDDDR6 است که تنها با سرعت ۱ ترابایت در ثانیه کار می کند.

به هر حال، بر اساس گزارشها، H200 از شش ماژول ۲۴ گیگابایتی HBM3E 8H از Micron استفاده میکند (مجموع ۱۴۴ گیگابایت اما فقط ۱۴۱ گیگابایت قابل استفاده). همین ظرفیت را می توان تنها با چهار ماژول ۱۲H به دست آورد، در عوض، ظرفیت ۲۱۶ گیگابایتی را می توان با شش ماژول ۱۲H به دست آورد.

بر اساس برآوردهای سامسونگ، ظرفیت اضافی طراحی جدید ۱۲H آن، سرعت آموزش هوش مصنوعی را تا ۳۴ درصد افزایش میدهد و به سرویسهای استنتاج اجازه میدهد «بیش از ۱۱.۵ برابر» تعداد کاربران را مدیریت کنند.

رونق هوش مصنوعی شتابدهندههایی مانند H200 را در تقاضای بالا نگه میدارد، بنابراین تامینکننده حافظه کاری سودآور است – میتوانید ببینید که چرا شرکتهایی مانند Micron، Samsung و SK Hynix میخواهند تکهای از کیک را داشته باشند.